这其实不只是针对于discuz这个程序建的网站,针对所有的网站都有效。网站的根目录有一个robots.txt文件。这个就相当于一个协议。它告诉搜索引擎,你可以抓取我网站里的哪些内容。所以,想要禁止搜索引擎抓取网站内容,就得在这个文件里进行操作。

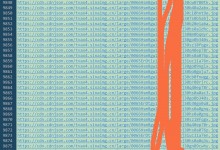

先看一下discuz默认的robots.txt内容:

User-agent: *

Disallow: /api/

Disallow: /data/

Disallow: /source/

Disallow: /install/

Disallow: /template/

Disallow: /config/

Disallow: /uc_client/

Disallow: /uc_server/

Disallow: /static/

Disallow: /admin.php

Disallow: /search.php

Disallow: /member.php

Disallow: /api.php

Disallow: /misc.php

Disallow: /connect.php

Disallow: /forum.php?mod=redirect*

Disallow: /forum.php?mod=post*

Disallow: /home.php?mod=spacecp*

Disallow: /userapp.php?mod=app&*

Disallow: /*?mod=misc*

Disallow: /*?mod=attachment*

Disallow: /*mobile=yes*

Disallow的意思就是不允许抓取。好了,我们最终把上面的代码改成下面内容:

User-agent: *

Disallow: /

这样就是网站根目录下的所有内容都不允许抓取。

自学控 - 自己建站也轻松

自学控 - 自己建站也轻松